Claude在“道德输出”方面优于GPT-4?详解背后逻辑

一、Claude的道德输出设计理念

Claude由Anthropic公司开发,致力于创造一种更为“安全”和“合规”的人工智能模型。Claude的设计理念与许多其他语言模型不同,其特别关注AI行为的可控性和道德合规性。Claude的训练过程中,采用了一种特殊的方式,使得其在生成内容时更加注重避免出现有害、恶意或偏见的输出。

1. 安全性优先

Claude模型的核心目标之一是提高AI系统的安全性,尤其是在生成内容时避免输出可能引发伦理争议的文本。Claude会尽量避免生成带有种族歧视、性别偏见、仇恨言论、暴力或不道德内容的文本。它会通过对文本进行更严格的筛选和审查,确保生成内容符合一定的道德和社会规范。

2. 道德框架

Claude被设计为遵循明确的道德框架,这使得其在生成文本时能够避免触及敏感话题或产生负面影响。例如,在生成与健康、法律、社会政治等相关的内容时,Claude会特别小心,确保所提供的内容是合规且无害的。Claude的开发团队在训练时就加入了大量与伦理合规相关的数据,以使模型更好地识别并规避潜在的道德风险。

3. 持续的监督与调整

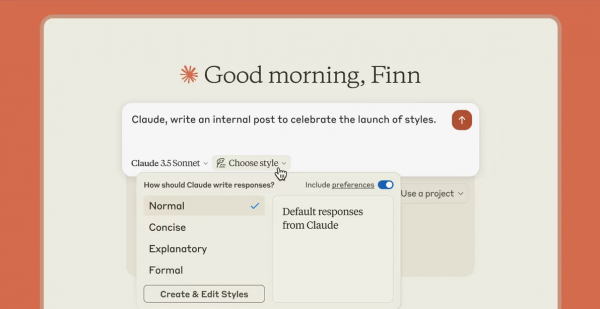

Claude模型背后有一个持续的监督机制。在训练过程中,Anthropic通过人类监督来调整Claude的输出,确保其不会偏离道德规范。通过反馈机制,Claude能够学习如何避免生成有害内容,不断优化其输出质量。这一机制使Claude在生成内容时更加“安全”且符合社会伦理。

二、GPT-4的道德输出机制

GPT-4由OpenAI开发,虽然同样具备强大的文本生成能力,并有一定的道德输出控制机制,但与Claude相比,它的设计和实施上存在一些差异。

1. 灵活性与多样性

GPT-4的设计更注重灵活性和适应性,能够生成多样化的文本,处理复杂的任务和情感。然而,这种灵活性也带来了一些挑战。GPT-4的生成内容可能在某些情况下不符合道德标准,尤其是在处理敏感话题时。GPT-4的输出会根据不同的提示和上下文调整生成内容,因此,如果没有足够的约束和审查机制,它可能生成带有偏见、恶意或争议的文本。

2. 内容过滤与监督

尽管OpenAI为GPT-4设计了一些内容过滤和安全措施,例如通过增强的提示调控和后处理来避免生成不当内容,但这些措施在某些情况下可能不够完备,特别是面对复杂的道德和伦理判断时。GPT-4的内容过滤机制依赖于其训练数据和设计规则,但由于其生成能力的多样性,过滤效果可能存在漏洞。

3. 生成输出的风险

GPT-4在一些特定情境下,尤其是对敏感话题的处理上,可能会生成带有潜在争议的内容。这并不是因为GPT-4“有意”生成不当内容,而是由于其在处理开放式、自由格式文本生成时,模型难以完全规避所有可能的道德风险。

三、Claude与GPT-4的道德输出对比

1. 道德合规性与内容控制

Claude的设计使其在道德合规性方面更为突出。Claude特别重视生成内容的道德合规性,尤其是在涉及敏感话题时,如性别、种族、暴力等,Claude的设计会更多地依赖人工监督和规则筛选,以保证其输出符合道德标准。GPT-4虽然也有道德过滤机制,但其灵活性较强,有时可能无法完全避免产生有偏见或争议的内容,尤其在生成长文本或面对复杂话题时。

2. 生成内容的准确性与安全性

Claude的安全性优先,意味着它更倾向于生成保守且合规的内容。尽管这可能导致Claude生成的内容在创意和表现上相对保守,但其确保输出无害的能力使得Claude在一些严格要求道德合规的场景中更为合适。相比之下,GPT-4则更注重输出的多样性和表现力,在一些创意性内容的生成上表现得更加灵活,但这也意味着它在生成内容时存在一定的道德风险。

3. 适用场景

- Claude:适合用于需要高度道德合规的场景,如医疗、法律、教育等领域,特别是那些涉及敏感信息或需要遵循严格道德规范的任务。Claude的生成内容更符合社会伦理和法律标准,是面向企业或需要合规的应用场景的理想选择。

- GPT-4:适用于创意写作、复杂分析或多轮对话等场景,尤其是当需要更高的文本创意和多样性时。然而,对于涉及高度道德审查的领域,GPT-4可能需要更多的人工干预和内容审查,尤其在处理敏感话题时。