Claude与Transformer架构的演化关系详解(附图示)

自从Transformer架构在2017年横空出世,AI语言模型的“脑子”就发生了质的飞跃。从GPT、BERT、T5到Claude,虽然名字越来越多,但它们的“根”都扎在Transformer的这棵大树上。

那么问题来了:Claude的脑子,跟原版Transformer相比,进化了哪些?今天我们就从技术脉络梳理出Claude的“血统关系”,带你用通俗方式看懂它的架构演化史。

🧠 一、什么是Transformer?Claude的“祖先”

在NLP圈,“Transformer”就像蒸汽机之于工业革命。它是Google于2017年提出的一种神经网络结构,核心发明是自注意力机制(Self-Attention)。

简而言之:

传统模型像流水线——一字一句看过去;

Transformer像群聊——每个词都能“看到”所有其他词,再决定自己该说啥。

📌 核心结构图(建议配图示):

输入文本 → 位置编码 → 多头自注意力层 → 前馈神经网络 → 输出向量

这个架构成为后来所有大模型的基石,包括GPT系列、BERT家族、Claude……都是它的“后代”。

🔬 二、Claude是基于Transformer,但有何不同?

Claude的底层依然是Transformer,但Anthropic对其进行了多层次的“魔改”,使它在对话理解、安全性、长文本处理方面表现更好。关键演化点如下:

1. 架构优化:更适合长上下文处理

Claude在架构设计上可能采用了类似FlashAttention、线性注意力或稀疏注意力机制,大幅提升了对百万字级上下文的处理能力。

对比GPT-3只能看2048个token,Claude最高支持超百万tokens,这就是“记性碾压”。

📌 建议配图示:

Claude 与 GPT-3、GPT-4 的上下文长度比较条形图。

2. 安全性控制:引入 Constitutional AI 机制

Claude的一大亮点是采用**“宪法式训练”**方式,这与Transformer原生设计无关,但是训练流程的重要“演化支线”。

它不是结构变了,而是加了更智能的“行为规范系统”,比如让模型自我判断“回答合不合适”。

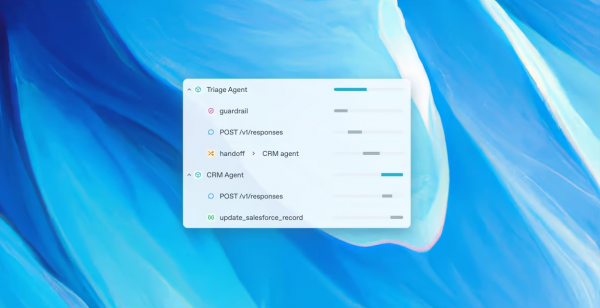

3. 对话与多轮上下文理解优化

Claude在处理长对话时表现出更强的对话连贯性与意图追踪能力。这可能通过以下技术演进实现:

- 更好的token压缩与表示方式

- 高效的注意力裁剪策略

- 精调数据集中强化人类意图理解

📌 建议配图示:

Claude 对话记忆链条 vs. 标准Transformer的 token 截断机制(对比图)

📊 Claude架构演化图(图示结构建议)

可使用如下图示结构辅助可视化 Claude 与 Transformer 的演化关系:

Transformer (2017)

↓

GPT/BERT系列(多模态预训练)

↓

Claude 基于 Transformer

+ 长上下文优化

+ Constitutional AI 训练

+ 安全性策略注入

↓

Claude 3 / Claude 3.5 系列(对话理解 & 任务泛化能力大增)

🎯 总结:Claude不是推翻Transformer,而是在“进化”Transformer

Claude的架构本质上仍是Transformer,但Anthropic通过算法调优 + 安全机制 + 训练理念三管齐下,让它从“语言模型”进化成了一个更有逻辑、更安全、更能记住你话的AI助手。

你可以把Claude想象成Transformer的“学霸后代”:血统纯正、家教严格、逻辑优秀——不是最浮夸的,但很值得信任。